英伟达在GB200和B200发布仅6个月后,再次推出全新GPU——GB300和B300。这看似只是小幅升级,实则蕴含着巨大的变革,尤其是推理模型性能的显著提升,将给整个行业带来深远的影响。

B300/GB300:推理性能的巨大飞跃

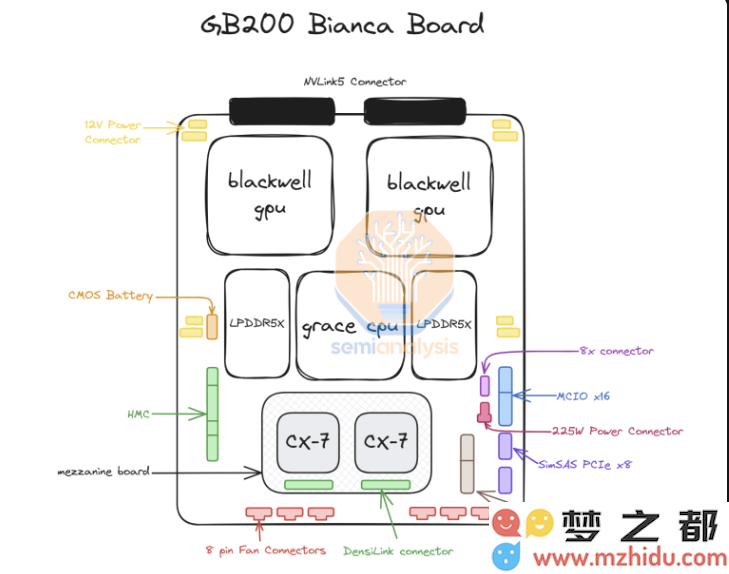

B300GPU采用台积电4NP工艺节点,针对计算芯片进行了优化设计。这使得B300的FLOPS性能比B200提升了50%。部分性能提升来自TDP的增加,GB300和B300HGX的TDP分别达到1.4KW和1.2KW(GB200和B200分别为1.2KW和1KW)。其余的性能提升则来自架构增强和系统级优化,例如CPU和GPU之间的动态功率分配。

除了FLOPS的提升,内存也升级为12-Hi HBM3E,每个GPU的HBM容量增加到288GB。然而,引脚速度保持不变,因此每个GPU的内存带宽仍为8TB/s。值得注意的是,三星未能进入GB200或GB300的供应链。

此外,英伟达在定价方面也做出了调整。这将在一定程度上影响Blackwell产品的利润率,但更重要的是,B300/GB300的性能提升将主要体现在推理模型方面。

为推理模型量身打造

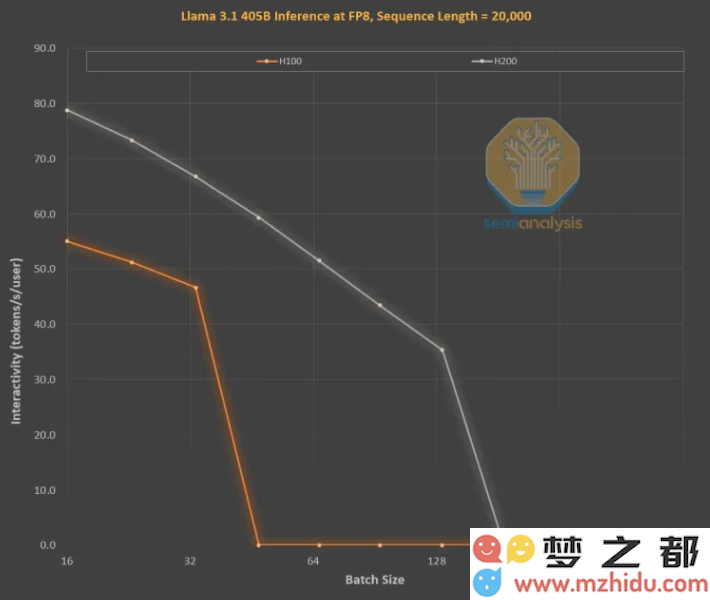

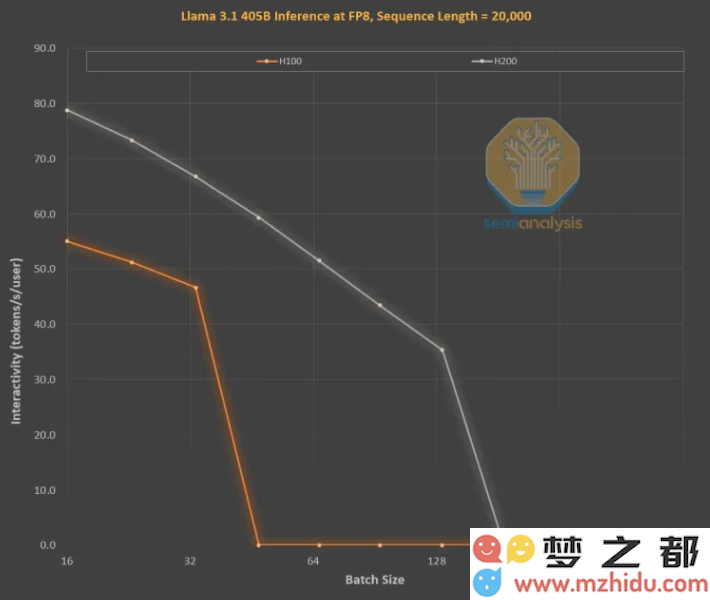

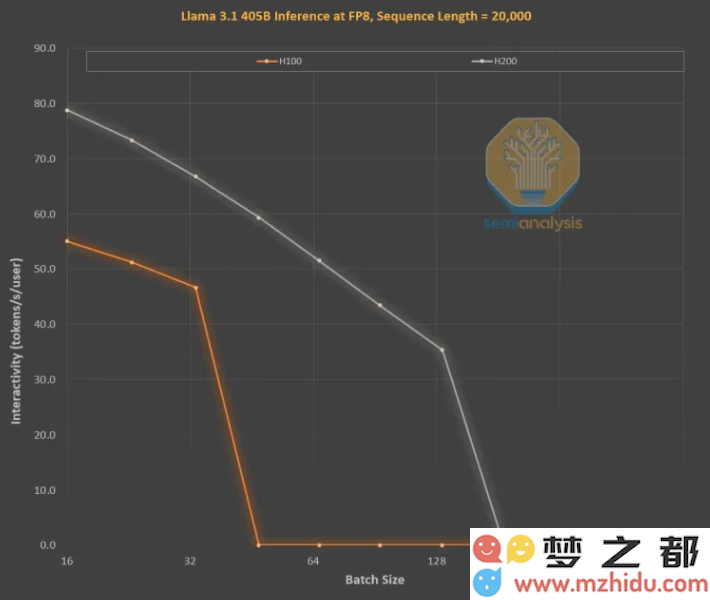

内存的改进对于OpenAI O3风格的LLM推理训练至关重要,因为长序列会增加KVCache,从而限制关键批处理大小和延迟。从H100到H200的升级(主要是内存的增加),带来了以下两方面的改进:

更高的内存带宽(H200为4.8TB/s,H100为3.35TB/s)使得所有可比较的批处理大小的交互性普遍提高了43%。

由于H200运行的批处理大小比H100更大,每秒生成的token数增加了3倍,成本降低了约3倍。这种差异主要是由于KVCache限制了总批处理大小。

更大的内存容量对性能的提升是巨大的。两款GPU之间的性能和经济差异远大于其参数规格所显示的:

推理模型的用户体验可能较差,因为请求和响应之间存在明显的等待时间。如果能够显著加快推理时间,将提高用户的使用意愿和付费意愿。

硬件通过中代内存升级实现3倍的性能提升是惊人的,远超摩尔定律、黄氏定律或我们所见过的任何其他硬件改进速度。